NIFI大数据进阶_离线同步MySql数据到HDFS_说明操作步骤---大数据之Nifi工作笔记0028

本文共 352 字,大约阅读时间需要 1 分钟。

然后我们看如何把mysql中的数据,实时的同步到hdfs中去

准备工作首先,创建一个mysql表,然后启动hadoop集群

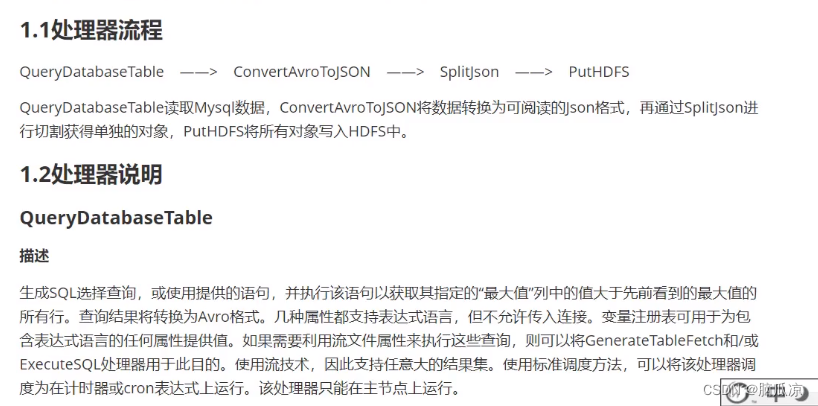

处理器我们需要这些处理器,首先通过querydatabasetable处理器,查询mysql中的数据,然后,把mysql中的数据,导入到

convertavrotojson处理器,注意querydatabasetable处理器,导出来的数据是avro格式的数据,然后再用

convertavrotojson把avro格式转换成json格式,然后再用splitjson,切割json数据,提取json中的数据,到splitjson的自定义属性中,然后再

用puthdfs处理器,提取splitjson切割好的,提取好的数据,拼接到puthdfs的命令中,就可以提交数据到hdfs中了

转载地址:http://zdjfk.baihongyu.com/

你可能感兴趣的文章

Netty工作笔记0057---Netty群聊系统服务端

查看>>

Netty工作笔记0060---Tcp长连接和短连接_Http长连接和短连接_UDP长连接和短连接

查看>>

Netty工作笔记0063---WebSocket长连接开发2

查看>>

Netty工作笔记0068---Protobuf机制简述

查看>>

Netty工作笔记0070---Protobuf使用案例Codec使用

查看>>

Netty工作笔记0072---Protobuf内容小结

查看>>

Netty工作笔记0074---handler链调用机制实例1

查看>>

Netty工作笔记0077---handler链调用机制实例4

查看>>

Netty工作笔记0081---编解码器和处理器链梳理

查看>>

Netty工作笔记0083---通过自定义协议解决粘包拆包问题1

查看>>

Netty工作笔记0084---通过自定义协议解决粘包拆包问题2

查看>>

Netty工作笔记0085---TCP粘包拆包内容梳理

查看>>

Netty常用组件一

查看>>

Netty常见组件二

查看>>

netty底层——nio知识点 ByteBuffer+Channel+Selector

查看>>

netty底层源码探究:启动流程;EventLoop中的selector、线程、任务队列;监听处理accept、read事件流程;

查看>>

Netty心跳检测

查看>>

Netty心跳检测机制

查看>>

netty既做服务端又做客户端_网易新闻客户端广告怎么做

查看>>

Netty核心模块组件

查看>>